OpenAI 将ChatGPT“语音模式”推迟至七月

快速导读

OpenAI宣布推迟了最新AI模型的"语音模式"功能的发布,需要额外一个月来提高内容检测能力和用户体验。公司计划在秋季之前通过小型用户群体测试这一功能,然后进行更广泛的推出。GPT-4o模型旨在提供更快的语音对话处理速度,几乎没有延迟,以满足日益增长的语音技术需求。这种升级代表了ChatGPT体验的重大转变,从最初的文本互动到图像和语音等功能的集成,增强了用户互动体验。主要科技公司也在投资于语音助手技术,以满足消费者需求。

OpenAI 延迟了 “语音模式” 的推出

OpenAI 宣布推迟最新 AI 模型的 “语音模式” 功能的发布。最初计划于六月底向有限的 ChatGPT Plus 用户群体进行阿尔法版推出,但公司现在需要额外一个月来满足其推出标准。这一延迟归因于持续的增强措施,旨在提高模型的内容检测能力和整体用户体验,以及扩展基础设施以实时响应,以满足数百万用户的需求。

测试和推出策略

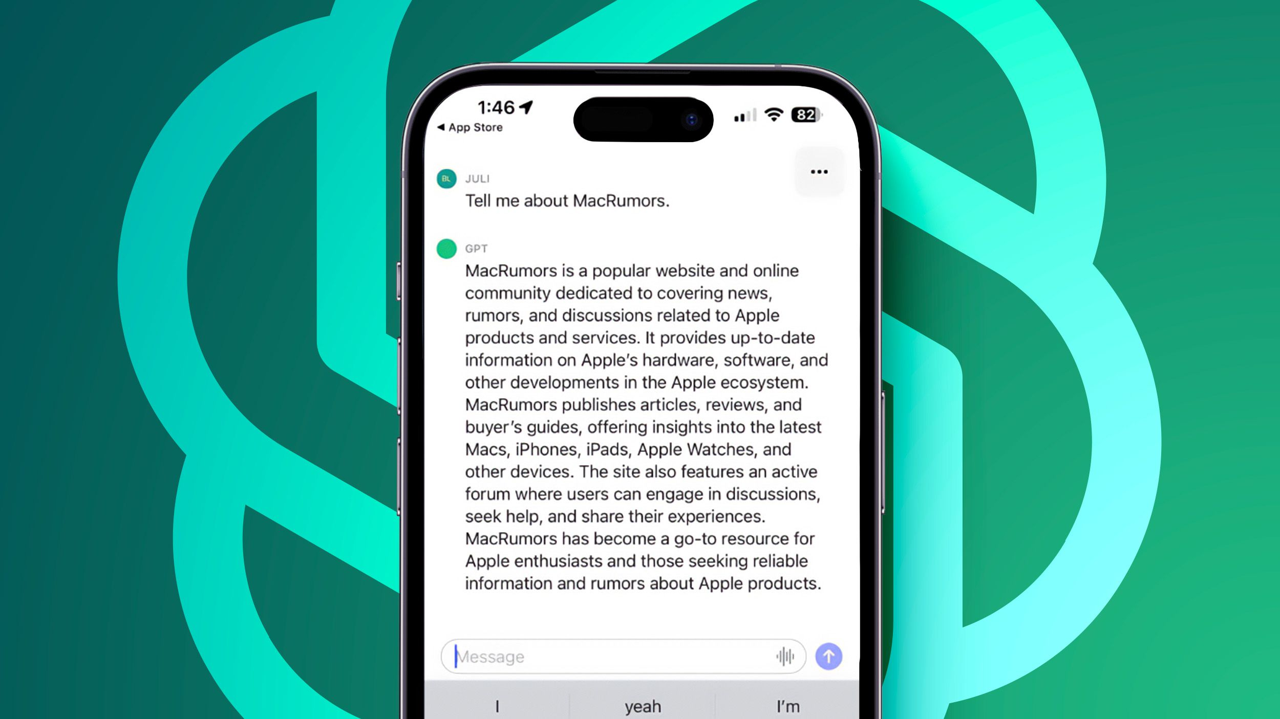

公司打算在秋季之前通过小型用户群体对 “语音模式” 功能进行初步测试,然后进行更广泛的推出,前提是经过彻底的安全性和可靠性评估。OpenAI 在五月推出了 GPT-4o 模型,旨在进行逼真的语音对话。随着语音助手在设置提醒和控制智能家居设备等任务中日益普及,亚马逊、苹果和谷歌等主要科技公司一直在大力投资于推进语音助手技术,以满足不断发展的消费者偏好。

用户体验的增强

OpenAI 的 GPT-4o 旨在利用对语音技术日益增长的需求,提供改进的易用性和处理速度。新模型具有实时对话和及时回答用户查询和请求的能力,而且几乎没有延迟。这种升级功能代表了传统 ChatGPT 体验的重大转变,最初侧重于基于文本的互动,然后才加入图像和语音等功能。最新 ChatGPT 版本中多模态功能的无缝集成增强了用户互动,使其更加直观,并类似于人类对话。

Tags