生成式人工智能对用户数据隐私的影响

退出选择的挑战

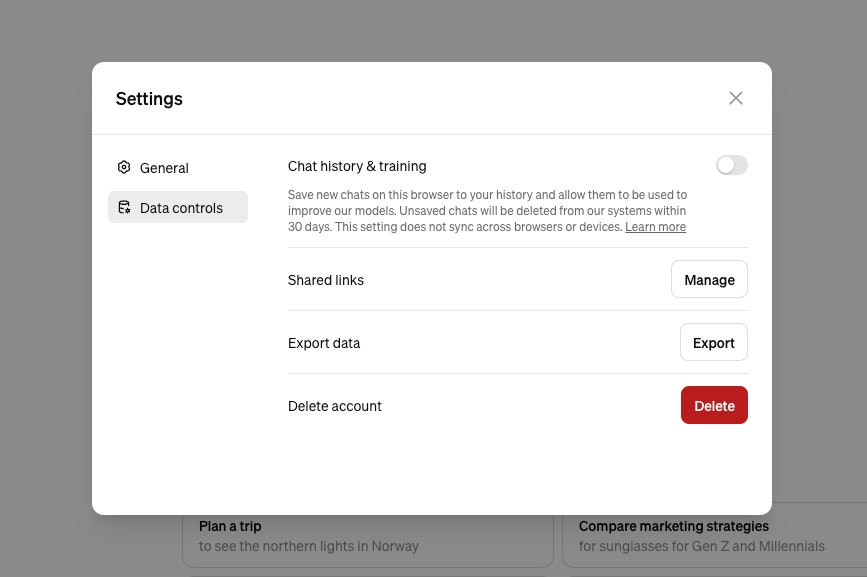

许多人工智能公司已经从网络上抓取了数据,这意味着用户在网上发布的任何内容很可能已经存在于他们的系统中。关于哪些数据已经被抓取、购买或用于训练的透明度不足,进一步复杂化了退出选择的过程。用户通常对他们授予的权限以及他们的数据如何被使用有限的了解。此外,版权保护和隐私法律等法律考虑因素增加了复杂性。虽然有技术方法可以从人工智能系统中删除数据,但实际的过程并不广为人知。公司往往让退出选择变得费时费力或隐藏选项,使用户难以行使自己的权利。

需要选择加入和用户意识

公司通常在涉及退出数据用于人工智能训练时制造摩擦。通过将选择加入作为默认选项,他们依赖用户的缺乏意识和主动行动。这种方法将责任转嫁给用户,要求他们主动寻找退出选项,而这些选项通常不容易获得。隐私活动家认为,公司应该将选择加入作为有意识的选择,确保用户充分了解数据使用的影响。然而,当前的趋势是朝着选择退出政策发展,使用户难以保护自己的数据免受用于人工智能训练的使用。

Tags